Diseñar y desarrollar un asistente virtual es, en cierto sentido, como dar a luz a un niño: cuando finalmente ve la luz, puedes pensar que la parte más difícil está terminada, ¡pero la aventura acaba de comenzar!

Mientras que en la gestión de proyectos tradicional el concepto de proyecto implica que algo tiene un principio y un final claro, un proyecto de IA conversacional no lo tiene. Por el contrario, comienza con la configuración de una nueva interfaz de conversación, pero en realidad no termina con su entrega, que es cuando el bot se activa.

Después de la puesta en marcha, hay infinitos pasos iterativos de seguimiento, análisis y mejora que te permiten comprender si tu producto es eficaz y encontrar las mejores estrategias para corregir los problemas.

Tabla de contenidos

Configurar el análisis correcto

Cuando configuras un panel para el análisis, debes elegir los criterios de evaluación cuantitativos y cualitativos que mejor se adapten a tus necesidades.

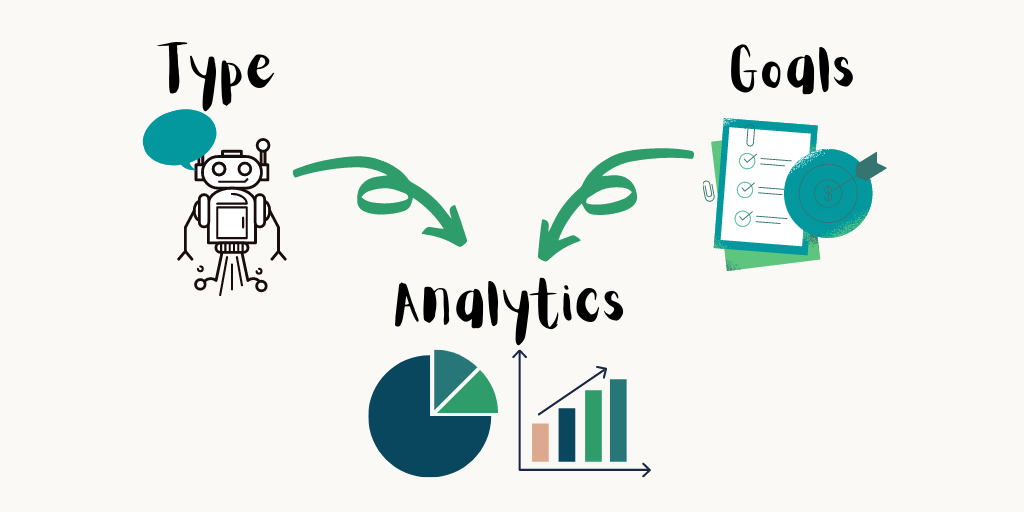

Para ello, primero debes definir cuál es el tipo y el objetivo de ese asistente virtual. Para configurar el bot Analytics correctamente, primero debes identificar el tipo y los objetivos de tu chatbot o voicebot.

Por ejemplo, si se trata de una interfaz conversacional basada en IA (es decir, puede comprender lo que escribe o dice en su idioma), el criterio crucial de evaluación es, por supuesto, su capacidad de comprensión. Si se trata de una aplicación de voz, una consideración adicional es la precisión del reconocimiento de voz.

Además, los diferentes objetivos requieren diferentes formas de evaluar el desempeño: ejemplos de estos objetivos son generar clientes potenciales, ayudar a los usuarios a navegar por productos y servicios, reducir la carga de servicio al cliente al proporcionar soluciones e información, etc.

Métricas para NLU / Comprensión

Evaluar el nivel de comprensión de un asistente virtual significa verificar cómo está funcionando el modelo NLU (Natural Language Understanding) y luego proceder con su ajuste fino.

Hay dos KPI para monitorear al analizar conversaciones desde esta perspectiva:

- Porcentaje de “no coincidencia”: ¿cuánto comprende el bot?

- Porcentaje de “coincidencia”: ¿cuánto se entiende correctamente?

Profundicemos más en ambos KPI.

No-match: ¿Cuánto comprende el bot?

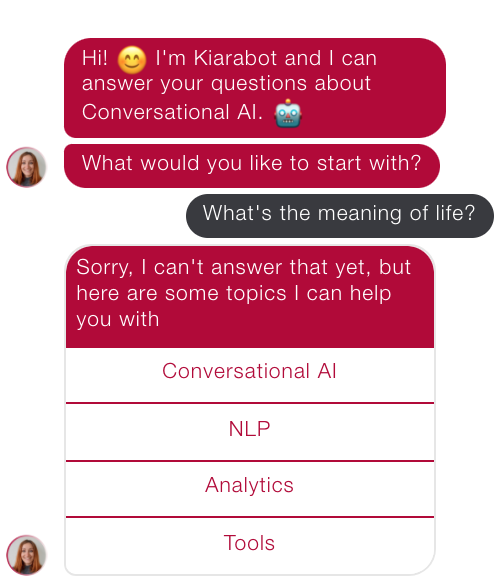

Para dar respuesta a esta primera pregunta, debemos tener en cuenta el porcentaje de casos en los que el bot no asocia el enunciado del usuario a ninguno de los temas que puede manejar y proporciona un mensaje con variaciones del concepto “Lo siento, No entendí, ¿puedes repetir?”.

Esta “falta de comprensión” puede denominarse “No coinciden”, “Fallback” o con otras etiquetas que pueden variar de una plataforma a otra y de una empresa a otra.

Sin embargo, existen al menos dos tipos de “No coinciden”:

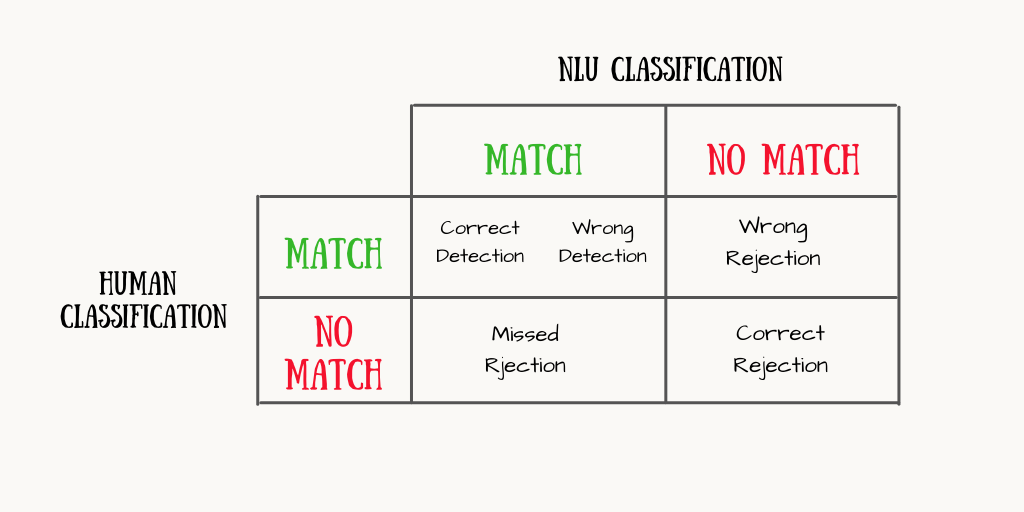

- Rechazos correctos: expresiones que no coincidían y que no deberían coincidir porque, por ejemplo, se refieren a un tema que no se ha enviado al asistente virtual (ejemplo a continuación). Sin embargo, si el nuevo tema se pregunta con frecuencia, se puede construir una nueva intención para tratarlo.

- Rechazos (o eliminaciones) incorrectos: expresiones que no coincidían pero que deberían haber coincidido, porque el tema al que se refieren se encuentra entre los que maneja el bot. En este caso, la única intervención posible es agregar nuevas frases de entrenamiento al modelo NLU para mejorarlo.

Coincidencia: ¿Cuánto se entiende correctamente?

En este segundo caso, el bot coincide con un tema, pero debemos averiguar si coincidió con el correcto o si ha habido una especie de malentendido.

Es importante medir el impacto de los tres tipos posibles de “Coincidencia”:

- Detecciones correctas (o aceptación correcta): el enunciado del usuario coincidía con el tema correcto.

- Detecciones incorrectas (o aceptación falsa): la expresión del usuario debería haber coincidido con un tema, pero coincidió con otro (ejemplo en inglés en la próxima imagen).

- Rechazos perdidos (o adiciones): la expresión del usuario no debería haber coincidido con ninguno de los temas tratados por el bot, pero coincidió con uno.

Métricas para la experiencia conversacional

Aparte de las métricas de NLU, el otro área a analizar es la de la experiencia conversacional general.

Estos pueden variar de Asistente virtual a Asistente virtual.

Por ejemplo, un KPI que puede ser doble es la Duración de la sesión: en un chatbot de servicio al cliente, las conversaciones breves podrían verse como un indicador muy positivo, porque brindan información y soluciones rápidamente; por el contrario, en una generación de prospectos, las conversaciones breves serían un indicador negativo, lo que significa que los usuarios no se involucran, no llegan al final del flujo y, en última instancia, no dejan ninguna información sobre sí mismos.

Otra cosa a considerar es la diferencia entre métricas cuantitativas y cualitativas. Los primeros proporcionan datos sin procesar; son más fáciles de extraer, pero suelen ser engañosas si no las analizan analistas expertos. Estos últimos son más difíciles de extraer y requieren más esfuerzo humano, pero brindan información más profunda.

Las métricas de bot cuantitativas se centran en números y datos brutos, las métricas de bot cualitativas se centran en una evaluación crítica de esos datos

A continuación, presentamos algunas sugerencias de métricas cuantitativas que podrían resultar útiles para comprender si una interfaz de conversación es eficaz:

- Número de conversaciones e interacciones: ¿los usuarios utilizan realmente el producto de todos sus esfuerzos? ¿Puede encontrar formas de solicitar más interacciones?

- Duración de las conversaciones: esa es una métrica complicada, porque una conversación larga puede significar: A) a los usuarios les gusta chatear con tus chatbots o voicebot y así interactuar en múltiples turnos, o B) que no entienden tus respuestas, dedican demasiado tiempo a leerlos porque son demasiado largos y complejos o, en general, no pueden encontrar la información que buscan.

- Distribución de interacciones por día de la semana y hora del día: ¿cuándo prefieren interactuar los usuarios? ¿Hay algún pico? Si tienes que realizar cambios en la producción, es posible que desees evitar los períodos de tiempo más populares para las interacciones.

- Interacción libre frente a botones: ¿cuál es el porcentaje de usuarios que interactúan libremente usando lenguaje natural y el de usuarios que interactúan haciendo clic en botones, carrusel y plantillas visuales? ¿Es una distinción significativa?

- Canales: ¿cuál es la distribución de los usuarios en los múltiples canales en los que está activo el asistente? ¿Y por qué los usuarios prefieren uno sobre los demás?

- Principales intenciones: ¿Cuáles son las preguntas más frecuentes? Si tienes que hacer alguna mejora, es posible que desees priorizar estos temas.

Muchas plataformas de creación de bots tienen métricas de análisis integradas, y también hay algunas plataformas externas que se pueden integrar fácilmente para extraer datos cuantitativos, como Dashbot, Tableau, Mixpanel o Matomo, por nombrar algunas.

En cuanto a las métricas cualitativas, en mi opinión, las más importantes son:

- Puntos débiles: todas las desviaciones frecuentes de los caminos conversacionales diseñados; podrían ser respuestas inesperadas a las preguntas del bot, solicitudes de explicaciones, etc.

- Conversaciones terminadas prematuramente: ¿en qué pasos los usuarios cuelgan o dejan de chatear? ¿Y por qué? Mire hacia atrás en el historial de la conversación e intente encontrar las razones.

- Sentimiento: el análisis de sentimiento (o polaridad) determina si los usuarios en general expresan una opinión positiva o negativa mientras interactúan.

Comentarios explícitos

Finalmente, la forma más sencilla de evaluar el rendimiento de tu Asistente virtual es preguntar a las personas que realmente lo usan: tus usuarios.

La retroalimentación explícita se puede dar de varias formas diferentes, dependiendo del enfoque de los analistas. Pueden ser preguntas múltiples o una sola, pueden investigar un solo aspecto o varios, la pregunta puede ser abierta o proporcionar respuestas sugeridas, y las respuestas pueden ser textos, números o símbolos (ejemplo a continuación).

Conclusión

En resumen, la puesta en marcha es solo el comienzo de un proyecto de IA conversacional.

Sin embargo, “criar” un chatbot o robot de voz recién nacido y luchar para hacerlo cada vez más eficaz es otro tipo de desafío. Requiere un análisis cuidadoso del rendimiento del bot, teniendo en cuenta criterios específicos que varían de un proyecto a otro, según el tipo y los objetivos del asistente virtual.

¿Estás de acuerdo con estas métricas? ¿Qué otros KPI utilizas para evaluar tus chatbots y voicebots? ¿Cómo configuras tu bot Analytics? ¡Háznoslo saber en los comentarios!