El año 2022 fue testigo del lanzamiento de NLU con inmensas capacidades generativas junto con lo que se puede denominar medios sintéticos. También asistimos al auge de un nuevo campo llamado Ingeniería de Prompt y de la disciplina del Diseño de NLU. En este artículo considero cuatro tendencias en inteligencia artificial conversacional y las implementaciones prácticas de la tecnología CAI que verán avances en su aplicación práctica.

Las cuatro tendencias a tener en cuenta en 2023 son:

1️⃣ Capacidades generativas de los grandes modelos lingüísticos o Large Language Models (LLM).

2️⃣ Diseño de NLUs que cierran la brecha de datos en los LLMs.

3️⃣ Adopción de robots de voz y tecnologías afines.

4️⃣ Mayor fragmentación a través de la implantación de nichos de mercado.

🌟 ¡Sígueme en LinkedIn para otras novedades relacionadas con la IA Conversacional! 🙂

Tabla de contenidos

1️⃣ LLM generativos

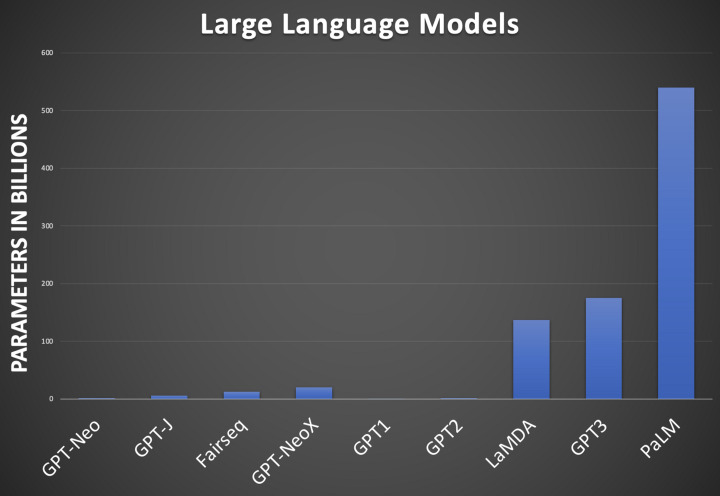

El número de LLM está aumentando en tamaño y capacidades generativas. Aunque las capacidades generativas gráficas de los LLM están aumentando, es la implementación práctica de las capacidades de generación de texto lo que hará que el uso de los LLM se generalice. Especialmente las implementaciones en Chatbots y Voicebots.

Durante 2022 HumanFirst anunció la integración con el LLM Cohere y otros LLMs. Yellow AI anunció DynamicNLP que aprovecha los LLMs, añadiendo a esta lista Oracle Digital Assistant y Amelia.

Relacionado con los LLM y la generación de lenguaje está KI-NLP. Meta AI acuñó el término Knowledge Intensive NLP (KI-NLP). KI-NLP es la noción en la que se aprovecha un LLM para responder a preguntas generales de dominio abierto de forma conversacional. El usuario puede definir el formato de las respuestas, ya sea resumido, extenso, simplificado, etc.

ChatGPT es la implementación más reciente de un sistema KI-NLP en el que los usuarios pueden formular preguntas de dominio general. La API lingüística de OpenAI es excelente para responder a preguntas generales.

Teniendo en cuenta los esfuerzos de Google en el espacio LLM, recientemente esta compañía anunció su modelo PaLM mientras que LaMDA sólo está disponible en una vista previa muy limitada.

Aquí es donde OpenAI realmente se diferencia, haciendo que sus modelos como ChatGPT estén ampliamente disponibles para pruebas y comentarios. Especialmente con el lanzamiento del nuevo modelo Da Vinci hubo una excepcional cobertura boca a boca.

🌟 ¡Sígueme en LinkedIn Para Actualizaciones De IA Conversacional! 🙂

2️⃣ Diseño de NLU

El concepto de cerrar la brecha de datos entre los LLM generativos y predictivos fue articulado recientemente por Alexander Ratner en un post de LinkedIn.

La funcionalidad de los LLM puede dividirse en dos categorías principales: generativa y predictiva.

Las intenciones o la determinación de la intención de los enunciados del usuario (clasificación de enunciados del usuario) pueden considerarse una implementación de un enfoque predictivo.

Al considerar la predicción LLM (clasificación), un aspecto viene a la mente… ¡la brecha de datos! Para que los modelos predictivos sean precisos, es necesario un nivel de ajuste fino del LLM; este proceso aborda el problema que algunos denominan brecha de datos.

Los modelos generativos funcionan con un enfoque de aprendizaje de pocos disparos y la preparación de los datos de entrenamiento no es tan crucial como en el caso de un modelo predictivo.

Para las aplicaciones predictivas, la preparación de los datos es clave, ya que los datos no estructurados se convierten en datos de entrenamiento o datos de diseño NLU.

Puedes leer más sobre un ejemplo práctico de puesta a punto de un NLU aquí. Este es un ejemplo en el que se utiliza el diseño NLU para convertir datos no estructurados en datos de entrenamiento NLU estructurados para un LLM.

3️⃣ Voicebots

Dos cosas que destacaron de 2022 son la necesidad de obtener valor de las implementaciones de IA junto con la automatización en el centro de contacto.

Los clientes siguen prefiriendo llamar por teléfono a los call centers y el santo grial de la IA conversacional es automatizar estas llamadas entrantes.

Durante la cumbre Modev Voice’22 en Arlington se hizo evidente que el foco se está alejando de las interfaces de voz dedicadas como Alexa y Google Home para centrarse significativamente en la automatización de voz en los call centers.

Un primer paso hacia las llamadas de voz totalmente automatizadas es descubrir y analizar las llamadas de voz grabadas. De ahí que las grabaciones de los clientes se conviertan en texto para la detección de intenciones y mucho más.

Otro elemento que alimenta la futura adopción masiva de voicebots son tecnologías como las voces de síntesis de voz personalizadas rápidas sin código, la creación de voces protésicas, las traducciones de idiomas de voz a voz, entre otras cuestiones.

4️⃣ Mayor fragmentación

Como he mencionado antes, de la investigación de Gartner se desprende que no se obtiene valor en la mayoría de las implementaciones cuando se trata de IA conversacional. Una forma de remediar este problema es limitar la huella de la implementación de la CAI. Por lo tanto, hay que empezar con una implantación pequeña e iterar a partir de esta implantación inicial.

Un segundo enfoque consiste en considerar los 18 casos de uso del Call center y optar por implantar la tecnología de IA en uno o sólo unos pocos de los casos de uso. En el nuevo año veremos cómo más empresas adoptan uno o varios de estos casos de uso como primera incursión en la IA conversacional.

La implantación de casos de uso específicos es más rentable y fácil de gestionar. Estos casos de uso específicos pueden extenderse después a otras áreas de la empresa.