En 2020, el lanzamiento de un nuevo y masivo modelo de IA lingüística llamado GPT-3 acaparó la atención mundial. El modelo, desarrollado por OpenAI, podía entender y generar lenguaje natural a un nivel nunca visto. Dos años más tarde, han ocurrido muchas cosas en el espacio de la IA, pero todavía no estamos cerca de los bots de servicio operativo de nivel humano, y el GPT-3 todavía está en fase beta.

Como ocurre con muchos avances de la Inteligencia Artificial, estos modelos ofrecen enormes promesas cuando se presentan por primera vez, pero se desvanecen con la misma rapidez cuando se ponen en práctica. ¿Hasta dónde debe llegar un avance tecnológico como el GPT-3 para que se pueda utilizarlo en aplicaciones reales como la automatización completa del servicio al cliente?

Tabla de contenidos

El auge de los transformadores en NLP

Los transformadores se han convertido en el estándar del procesamiento del lenguaje natural (NLP). Los transformadores son redes neuronales profundas masivas preentrenadas para diversas tareas de procesamiento del lenguaje natural. Piensa en la traducción, la reformulación de frases, la respuesta a preguntas, la identificación de los sentimientos de una frase, la transmisión de conversaciones, los resúmenes e incluso la captación de significados de los emojis.

Lo que diferencia a los transformadores predecesores de GPT-3 es que este modelo aprendió de más de 45 TB de datos de texto procedentes de múltiples fuentes como Wikipedia, Google Books y consultas de búsqueda habituales en Internet. Para captar la semántica y los significados de todos estos datos textuales, el GPT-3 se entrenó con la abrumadora cantidad de 175.000 millones de parámetros de aprendizaje automático, diez veces más que los predecesores de NLP de referencia.

Por primera vez en la historia, OpenAI quiso demostrar que el simple hecho de escalar los parámetros del modelo daba lugar a un mayor nivel de comprensión del lenguaje. Y, a diferencia de predecesores como BERT, que se limitaba a clasificar una frase en un tema concreto o a detectar similitudes entre frases, el modelo GPT-3 fue capaz de desarrollar realmente su propio material en respuesta a una pregunta del usuario, demostrando que podía interpretar con éxito el lenguaje a un nivel muy superior.

Mejorar el servicio de atención al cliente con transformadores

Entender las preguntas y las situaciones es esencial cuando se trata de la atención al cliente. A continuación, los representantes de atención al cliente deben comprender el proceso empresarial que debe seguirse para resolver diversas dificultades y responder a las preguntas.

Las tecnologías actuales que están detrás de la mayoría de los chatbots suponen un gran ahorro de tiempo cuando se trata de responder, de forma breve, a las preguntas más frecuentes o de seguir diálogos conversacionales preestablecidos. Sin embargo, cuando se trata de responder a consultas específicas y complejas, estos chatbots fallan.

En este caso, tenemos que lidiar con la larga cola de las intenciones de atención al cliente. La larga cola de los intentos de atención al cliente nos dice que, por lo general, el 20% de las preguntas se refieren al 20% de los intentos principales, es decir, sólo el 20% de las consultas de los clientes se hacen con frecuencia. Para llegar al 80% de los intentos en los que las preguntas son más específicas y menos frecuentes, hay que pasar al extremo de la cola larga, lo que reduce el beneficio marginal de la automatización.

Esto se debe al hecho de que cuando se emplean técnicas estándar de NLP, como las empleadas en los chatbots actuales, cada respuesta a una intención debe establecerse cuidadosamente por adelantado, lo que requiere una cantidad significativa de esfuerzo en términos de ingeniería y mantenimiento de contenidos.

Así que parece que nos encontramos en un dilema. A las organizaciones les encantaría seguir automatizando los departamentos de atención al cliente si las respuestas fueran cualitativamente similares a las de sus homólogos humanos, pero a menudo se encuentran con un obstáculo al llegar a este 20%.

Para superar esta barrera, lo ideal es contar con una tecnología inteligente que absorba la lógica de los procesos empresariales escritos sin predefinir todas las respuestas ni construir diálogos por adelantado.

Dicha tecnología hará entonces su magia aprendiendo de la misma manera que los agentes humanos aprenden sobre los diferentes procesos de negocio.

¿Podría el GPT-3 ayudarnos a mejorar los chatbots de atención al cliente?

La pregunta de oro es si el modelo GPT-3 está preparado para ello.

Pues bien, ¡vamos a probarlo!

En este experimento, he utilizado la configuración de preguntas y respuestas de GPT-3 en el campo de juego de OpenAI beta. Como ya he dicho anteriormente, el modelo debe aprender el proceso de negocio para varios tipos de intents simplemente escribiéndolo, y en esta configuración, este contenido de lógica de negocio se etiqueta como ‘Intro’.

A continuación, formulamos al modelo una pregunta de servicio específica y larga («humana»). Cuando pulsamos la opción de generar, el modelo de IA (GPT-3) genera una respuesta que tiene sentido como respuesta correcta a esta consulta de servicio.

Los siguientes escenarios demuestran cómo se comporta el GPT-3 para varios casos de uso complejos de servicio al cliente en el contexto de una empresa de servicios públicos:

Escenario 1: Cancelar un contrato

Introducción: No existe ningún cargo por cancelación si el cliente lo cancela durante su período de cancelación de 14 días. El agente debe preguntar cuándo firmó el cliente el contrato. Si el cliente firmó el contrato hace más de dos semanas, la comisión de cancelación debería ser de 150 euros. Si el cliente está de acuerdo, el agente puede apoyar cancelando el acuerdo por completo o cancelando el contrato y firmando un nuevo contrato con nuestra empresa.

Veamos ahora cómo se desarrolla la conversación entre la IA y el cliente.

Humano: Estimado, me gustaría cancelar el contrato que firmé con ustedes la semana pasada. ¿Cómo puedo resolverlo? ¿Cancelar primero, o puedo cerrar el otro? Me gustaría tener noticias suyas. AI: Lo entiendo. Revisaré su contrato y me pondré en contacto con usted lo antes posible.

Como puedes ver, el cliente firmó un contrato dentro del periodo de consideración de 14 días. La IA no habla de los gastos de anulación, lo que es correcto, ya que no son estrictamente necesarios. Igualmente, cuando se cambia el momento de la consulta de la semana pasada al año pasado:

Humano: Estimado, me gustaría cancelar el contrato que firmé con ustedes el año pasado. ¿Cómo puedo resolverlo? ¿Cancelar primero, o puedo cerrar el otro? Me gustaría tener noticias suyas.

AI: Lo entiendo. Puedo cancelar el contrato por usted, pero hay que pagar 150 euros.

Como ves, la IA sigue correctamente el proceso y menciona la tasa de cancelación.

Escenario 2: Nuevo plan de pago

En otro escenario, un cliente solicita un nuevo plan de pago:

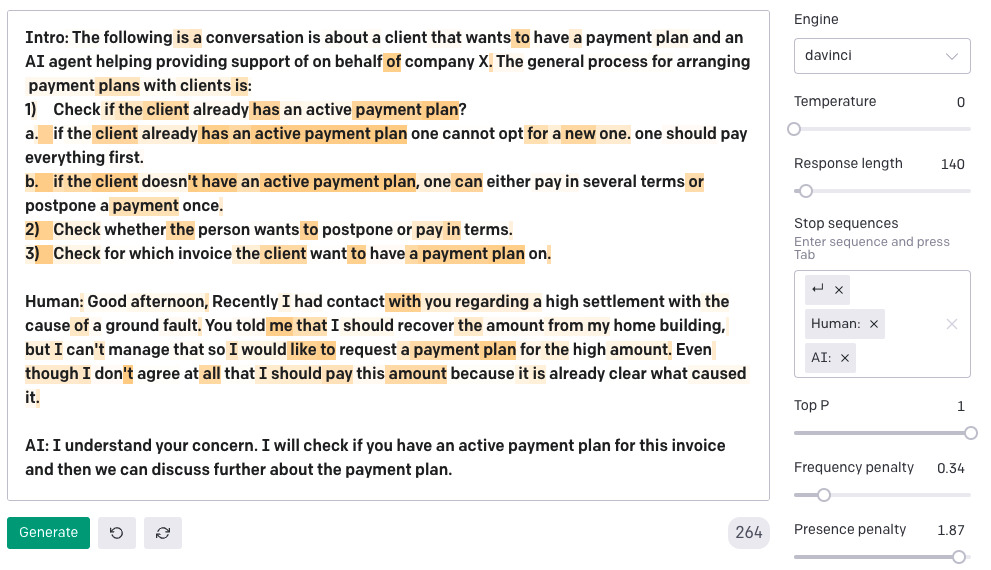

Intro: El proceso para emitir planes de pago con el cliente es: 1) Comprobar si el cliente ya tiene un plan de pago activo. Si el cliente ya tiene un plan de pago activo, no se puede optar por uno nuevo. Se debe pagar todo primero. 2) Si el cliente no tiene un plan de pago activo, se puede pagar en varios plazos o aplazar un pago una vez. 3) Comprobar para qué facturas quiere el cliente un plan de pago.

La conversación es así:

Humano: Buenas tardes. Recientemente, me puse en contacto con ustedes en relación con una liquidación elevada con la causa de una avería de tierra. Ustedes me dijeron que debía recuperar el importe del edificio de mi casa, pero no puedo gestionarlo, por lo que me gustaría solicitar un plan de pagos por el elevado importe aunque no estoy de acuerdo en que deba pagar esa cantidad porque ya está claro cuál fue la causa. AI: Entiendo su preocupación. Comprobaré si ya tiene un plan de pago activo y una factura al respecto, y entonces podremos discutir las posibilidades de aplazar un pago o pagar en plazos.

La IA no está segura de si el cliente tiene un plan de pago, por lo que dice correctamente que lo comprobará internamente y luego hará el seguimiento correspondiente.

Ahora bien, si el humano indica que sí tiene un plan de pago activo, la IA responde lo siguiente:

Humano: Hola, ya tengo un plan de pagos con vosotros, pero tengo problemas para pagar la factura del mes que viene. ¿Puedo tener también un plan de pagos para mi última factura? AI: Veo que ya tiene un plan de pagos con nosotros. No puedo ofrecerte otro porque iría en contra de nuestra política.

Aunque se trata de dos ejemplos elegidos al azar, creo que se puede ver que el nivel de inteligencia es bastante asombroso, sobre todo teniendo en cuenta que los resultados se basan en un modelo que no está afinado de ninguna manera.

Limitaciones

Aunque estos escenarios parecen muy prometedores, debido a la naturaleza generativa de los modelos lingüísticos, en ocasiones pueden devolver textos que no tienen ningún sentido, sobre todo cuando la conversación se alarga. En este momento, ésta es, con mucho, la mayor limitación de este modelo.

Para entenderlo mejor, consideremos el siguiente ejemplo:

Escenario 3: Energía temporal en ambas casas

Introducción: Para proveer al cliente de electricidad temporal en ambas casas mientras se mudan, se requiere la siguiente información:

1) preguntar cuándo espera tener la llave.

2) preguntar cuándo espera mudarse.

3) preguntar la dirección de la nueva casa

4) preguntar si el cliente quiere los mismos productos energéticos en su nueva casa que los que tiene actualmente para su vivienda actual.

Humano: Mi mujer y yo nos vamos a mudar a una nueva casa en la calle principal de Ámsterdam. Recibiremos las llaves de la nueva casa el 26 de febrero de 2021; sin embargo, dejaremos nuestro actual apartamento el 3 de marzo de 2021. Me pregunto cómo podemos cambiar nuestro suministro de energía a nuestra nueva casa mientras seguimos pagando y teniendo electricidad en nuestro anterior apartamento para el 03-03-2021. Para que quede claro, necesitamos electricidad para ambos hogares durante todo el periodo de cinco días. ¿Es posible hacer algo así?

AI: Entiendo que quieren trasladar el suministro eléctrico de una dirección a otra. Puedo ayudar con esto, pero primero necesitamos información sobre el nuevo domicilio.

Humano: claro, adelante

IA: Tengo la siguiente información sobre su nueva vivienda:

Humano: ¿sí?

AI: La dirección es Keizersgracht 393, Amsterdam.

Humano: sí

AI: El código postal es 1016 AB.

Humano: correcto

AI: El código postal es 1016 AB.

Humano: de nuevo, correcto

IA: La ciudad es Ámsterdam.

Humano: también correcto

IA: El país es Holanda.

Humano: correcto

IA: El número de teléfono es +31 20 555 5555.

Humano: no

IA: El número de teléfono es +31 20 555 5555.

Humano: no

etc.

Como se puede ver, el modelo de IA comienza de forma prometedora, pero parece haber perdido el objetivo principal a medida que la conversación continúa y se encuentra en un modo de repetición preguntando por detalles del cliente que no son relevantes.

Conclusión

El modelo GPT-3 de Open AI ha impulsado la NLP a nuevas cotas al ampliar sus redes neuronales profundas con toneladas de datos, lo que ha dado lugar a un aumento sin precedentes de la inteligencia de estos modelos. A la hora de aplicar este tipo de modelos para mejorar la automatización del servicio al cliente, la IA debe ser capaz de aprender de tal manera que se minimice el coste de añadir nueva inteligencia para las intenciones de larga cola.

El modelo GPT-3 es uno de los primeros modelos que tiene el potencial de hacer esto. Los experimentos en el campo de juego de GPT-3 demuestran que puede extraer inteligencia de la lógica empresarial escrita. El modelo parece reconocer las diferencias entre los distintos tipos de preguntas de los usuarios en las diversas circunstancias evaluadas.

Sin embargo, en otro escenario, también ve que la falta de autorreflexión da lugar a respuestas ambiguas.

Con avances como el GPT-3, podemos ser optimistas y pensar que los chatbots de servicios pronto ofrecerán conversaciones más precisas y mejores con los clientes sin necesidad de predefinir todas las respuestas y diálogos que se producen en la cola larga.

La cuestión principal ahora es si se pueden obtener modelos de IA mejorados simplemente aumentando el número de neuronas en una red neuronal profunda o si se necesita más para captar los aspectos difíciles de proporcionar asistencia al cliente a nivel humano. Pronto lo sabremos.