Escrito por Orlando Torres en Planeta Chatbot.

Cuando las nuevas tecnologías se generalizan, a menudo plantean cuestiones éticas. Por ejemplo:

- Armas: ¿a quién se les debe permitir?

- Imprenta: ¿qué no debe ser publicado?

- Drones: ¿a dónde deberían poder ir?

Las respuestas a estas preguntas normalmente aparecen después de que las tecnologías se hayan vuelto lo suficientemente comunes como para que realmente surjan problemas. A medida que nuestra tecnología se vuelve más poderosa, los daños potenciales se harán más grandes. Teniendo en cuenta esto, creo que debemos pasar de ser reactivos a ser proactivos con respecto a los nuevos peligros tecnológicos.

Necesitamos comenzar a identificar los problemas éticos y las posibles repercusiones de nuestras tecnologías antes de que lleguen. Dado que la tecnología crece exponencialmente rápido, tendremos cada vez menos tiempo para considerar las implicaciones éticas.

Necesitamos tener conversaciones públicas sobre todos estos temas ahora . Estas son preguntas que la ciencia no puede responder: son preguntas sobre nuestros valores. Este es el reino de la filosofía, no de la ciencia.

La inteligencia artificial en particular plantea muchas cuestiones éticas; he aquí algunas que considero importantes. Esto es solo una introducción, incluyo muchos enlaces para aquellos que buscan profundizar.

Solo proporciono las preguntas: es nuestro deber como sociedad averiguar cuáles son las mejores respuestas y, con el tiempo, la mejor legislación.

Tabla de contenidos

1. Sesgos en algoritmos

Los algoritmos de aprendizaje automático aprenden de los datos de entrenamiento que reciben, independientemente de cualquier suposición incorrecta en los mismos. De esta forma, estos algoritmos pueden reflejar, o incluso magnificar, los sesgos que están presentes en los datos.

Por ejemplo, si un algoritmo está entrenado en datos que son racistas o sexistas, las predicciones resultantes también reflejarán esto. Algunos algoritmos existentes han etiquetado erróneamente a las personas negras como “gorilas” o han cobrado a los asiáticos estadounidenses precios más altos por la tutoría SAT. Algoritmos que intentan evitar variables obviamente problemáticas como “raza”, encontrarán cada vez más difícil desenredar posibles proxies para la raza, como códigos postales. Los algoritmos ya se están utilizando para determinar la solvencia crediticia y la contratación, y es posible que no pasen la prueba de impacto diferente que se usa tradicionalmente para determinar si algunas prácticas son discriminatorias.

¿Cómo podemos asegurarnos de que los algoritmos sean justos , especialmente cuando son propiedad privada de una empresa y no son accesibles al escrutinio público? ¿Cómo podemos equilibrar la apertura y la propiedad intelectual?

Usando Twitter para quejarse del sesgo algorítmico de Google

Usando Twitter para quejarse del sesgo algorítmico de Google

2. Transparencia de Algoritmos

Aún más preocupante que el hecho de que las empresas no permitirán que sus algoritmos sean examinados públicamente, es el hecho de que algunos algoritmos son oscuros incluso para sus creadores.

El aprendizaje profundo es una técnica de rápido crecimiento en el aprendizaje automático que hace muy buenas predicciones, pero no es realmente capaz de explicar por qué llegó a esa conclusión y no a otra. Por ejemplo, algunos algoritmos se han utilizado para despedir maestros , sin poder darles una explicación de por qué el modelo indicó que deberían ser despedidos.

¿Cómo podemos equilibrar la necesidad de algoritmos más precisos con la necesidad de transparencia hacia las personas que se ven afectadas por estos algoritmos? Si es necesario, ¿estamos dispuestos a sacrificar la precisión por la transparencia , como puede hacer el nuevo Reglamento General de Protección de Datos de Europa? Si es verdad que los humanos probablemente desconocen sus verdaderos motivos para actuar , ¿deberíamos exigir que las máquinas sean mejores en esto de lo que realmente somos nosotros?

Un algoritmo que es mucho más transparente que el aprendizaje profundo

Un algoritmo que es mucho más transparente que el aprendizaje profundo

3. Supremacía de Algoritmos

Una preocupación similar pero ligeramente diferente surge de los dos números anteriores. Si comenzamos a confiar en los algoritmos para tomar decisiones, ¿quién tendrá la última palabra sobre las decisiones importantes? ¿Serán humanos o algoritmos?

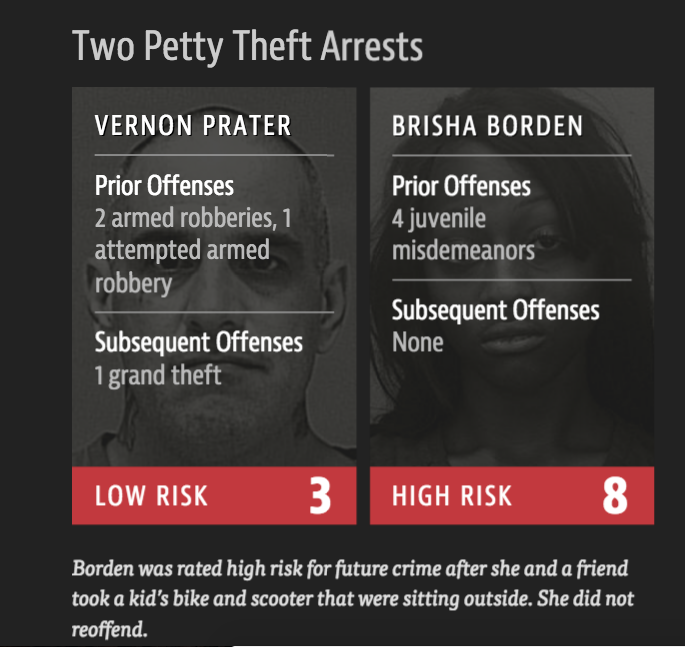

Por ejemplo, algunos algoritmos ya se están utilizando para determinar sentencias de prisión. Dado que sabemos que las decisiones de los jueces se ven afectadas por su estado de ánimo , algunas personas pueden argumentar que los jueces deberían ser reemplazados por “jueces robot”. Sin embargo, un estudio de ProPublica encontró que uno de estos populares algoritmos de sentencia era muy parcial en contra de los negros. Para encontrar un “puntaje de riesgo”, el algoritmo utiliza información sobre los amigos del acusado que nunca se aceptaría como evidencia tradicional.

¿Será que las personas deberían poder apelar porque su juez no era humano? Si los jueces humanos y los algoritmos de sentencia son parciales, ¿qué deberíamos usar? ¿Cuál debería ser el papel de los futuros “jueces robot” en la Corte Suprema?

Un estudio de caso de la investigación de ProPublica sobre el algoritmo de sentencia COMPAS

Un estudio de caso de la investigación de ProPublica sobre el algoritmo de sentencia COMPAS

4. Noticias falsas y videos falsos

Otra preocupación ética surge en torno al tema de (mis) información. El aprendizaje automático se usa para determinar qué contenido mostrar a diferentes audiencias. Dado que los modelos de publicidad son la base de la mayoría de las plataformas de redes sociales, el “tiempo de pantalla” se usa como la medida típica del éxito. Dado que los humanos son más propensos a involucrarse con más contenido inflamatorio, las historias parciales se propagan de forma viral. Del mismo modo, estamos a punto de usar herramientas de aprendizaje automático para crear vídeos virales falsos que sean tan realistas que los humanos no podrán diferenciarlos.

Por ejemplo, un estudio reciente mostró que las noticias falsas se propagan más rápido que las noticias reales. Las noticias falsas tenían un 70% más de probabilidades de ser retuiteadas que las noticias reales. Ante esto, muchos intentan influir en las elecciones y las opiniones políticas utilizando noticias falsas. Una investigación encubierta reciente sobre Cambridge Analytica los sorprendió en vídeo alardeando sobre el uso de noticias falsas para influir en las elecciones.

Si sabemos que los vídeos pueden ser falsificados, ¿qué será aceptable como evidencia en una sala del tribunal? ¿Cómo podemos reducir la propagación de información falsa, y cómo valoraremos si una noticia entra dentro de lo “verdadero”?

Izquierda: imagen real de la superviviente del tiroteo de Parkland Emma González. Derecha: imagen falsa que se volvió viral

5. Armas autonómas letales

Los investigadores de la IA dicen que seremos capaces de crear sistemas de armas autónomas letales en menos de una década . Esto podría ser en forma de pequeños drones que pueden desplegarse y, a diferencia de los drones militares actuales, ser capaces de tomar decisiones sobre matar a otros sin la aprobación humana.

Por ejemplo, un vídeo reciente creado por investigadores de IA muestra cómo los pequeños drones autónomos, Slaughterbots, podrían usarse para matar grupos específicos de personas, es decir, genocidio. Casi 4.000 investigadores de IA/ Robótica han firmado una carta abierta solicitando la prohibición de armas autónomas ofensivas.

¿Sobre qué base deberíamos prohibir este tipo de armas, cuando los países individuales desearían aprovecharlas? Si prohibimos esto, ¿cómo podemos asegurarnos de que no lleve la investigación a la clandestinidad y conduzca a que las personas las desarrollen independientemente?

Imagen del video “Slaughterbots”

6. Coches autónomos

Google, Uber, Tesla y muchos otros se están uniendo a este campo de rápido crecimiento, pero muchas preguntas éticas siguen sin respuesta.

Por ejemplo, un vehículo autónomo de Uber mató recientemente a un peatón en marzo de 2018. Aunque había un “conductor de seguridad” para emergencias, no fue lo suficientemente rápidos como para detener el coche a tiempo.

A medida que se despliegan más automóviles autónomos, ¿quién debería ser responsable cuando ocurran los accidentes? ¿Debería ser la empresa que fabricó el automóvil, el ingeniero que cometió un error en el código, el operador que debería haber estado mirando? Si un coche sin conductor va demasiado rápido y tiene que elegir entre chocar contra personas o caerse de un acantilado, ¿qué debería hacer el auto? Una vez que los coches autónomos sean más seguros que los conductores humanos promedio (en la misma proporción que los conductores humanos promedio son más seguros que los conductores ebrios) ¿deberíamos ilegalizar la conducción humana?

Imagen de la cámara del accidente de Uber

7. Privacidad vs Vigilancia

La presencia omnipresente de cámaras de seguridad y algoritmos de reconocimiento facial creará nuevos problemas éticos en torno a la vigilancia. Muy pronto las cámaras podrán encontrar y rastrear personas en las calles. Antes del reconocimiento facial, incluso las cámaras omnipresentes permitían privacidad porque sería imposible que los humanos vean todo el material de archivo todo el tiempo. Con el reconocimiento facial, los algoritmos pueden observar grandes cantidades de imágenes mucho más rápido.

Por ejemplo, las cámaras de CCTV ya están comenzando a usarse en China para monitorear la ubicación de los ciudadanos. Algunos policías incluso han recibido gafas de reconocimiento facial que pueden darles información en tiempo real de alguien que ven en la calle.

¿Debería haber una regulación contra el uso de estas tecnologías? Dado que el cambio social a menudo comienza como desafíos al status quo y la desobediencia civil, un panóptico puede conducir a una pérdida de la libertad y el cambio social?

Cámaras de vigilancia en China utilizando reconocimiento automático

Filosofía con una fecha límite

Hay personas reales actualmente sufriendo por estas tecnologías: son rastreados injustamente, despedidos, encarcelados e incluso asesinados por algoritmos sesgados e inescrutables.

Necesitamos encontrar la legislación apropiada para IA en estos campos. Sin embargo, no podemos legislar hasta que la sociedad tenga una opinión al respecto. No podemos tener una opinión hasta que comencemos a tener estas conversaciones y debates éticos. Vamos a hacerlo. Y tomemos el hábito de comenzar a pensar sobre las implicaciones éticas al mismo tiempo que concebimos una nueva tecnología.