El ecosistema de los chatbots se vio gravemente afectado por la llegada de los modelos lingüísticos y la IA generativa. Los líderes tuvieron que ingeniárselas para adaptarse e incorporar estas nuevas tecnologías. Mientras que otras empresas lo vieron como una nueva vía para entrar en el mundo de los chatbots y la IA conversacional.

Tabla de contenidos

Gartner

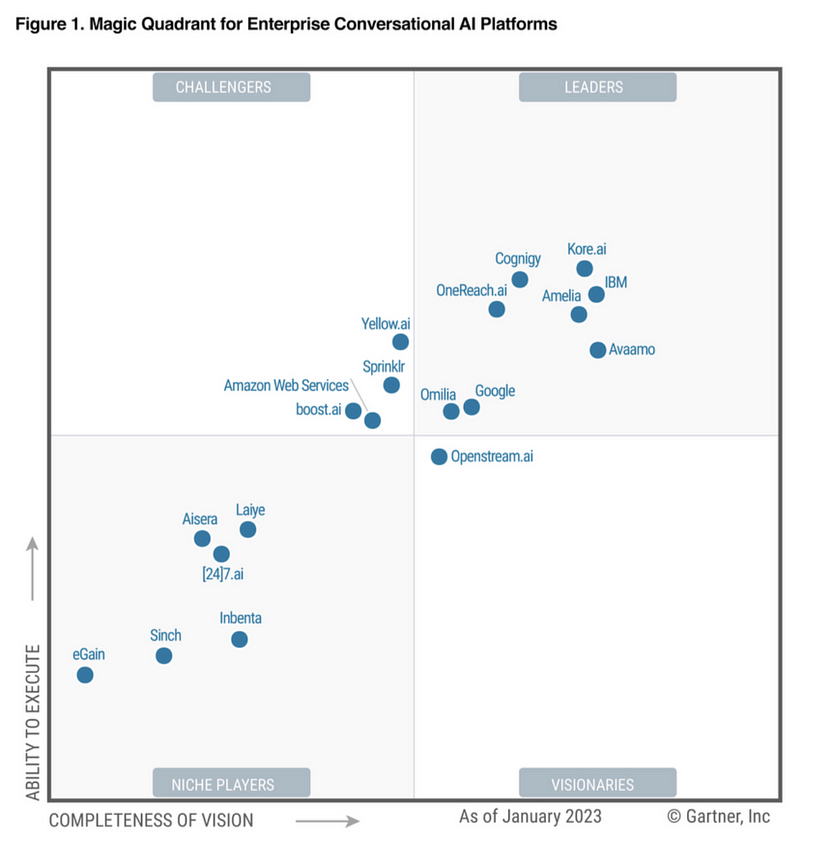

El trastorno fue tan grave que Gartner eliminó o interrumpió el Gartner Magic Quadrant para Plataformas de IA Conversacional Empresarial, del que Kore.ai era líder.

Si tuviera que aventurar una conjetura, diría que el Gartner Magic Quadrant para Plataformas Empresariales de IA Conversacional será sustituido por un Gartner Magic Quadrant para Agentes de IA.

Habrá que centrarse en el ecosistema del agente de IA, donde se aloja y vive el agente de IA. Con acceso a herramientas de despliegue y gestión y fácil acceso a los modelos. Los modelos comerciales y de código abierto deberían ser fácilmente accesibles y desplegables para una instancia privada propia.

Un segundo elemento que probablemente forme parte de los criterios es un marco de construcción en el que los Agentes de IA puedan desarrollarse sin código o con poco código.

Proveedores de tecnología

El panorama de los proveedores de tecnología de chatbot ha sido muy limitado y la mayoría de las empresas son nichos específicos de chatbot que se fundaron y existen con el único propósito de desarrollar y desplegar chatbots o interfaces de usuario conversacionales.

Hay empresas como Oracle, AWS, Google, Microsoft y otras que entraron en el mercado como una mera extensión de su oferta actual.

Sin embargo, lo que hizo que el mercado de chatbots / IA conversacional fuera tan atractivo es el hecho de que los actores de nicho más pequeños estaban dominando el mercado en gran medida. Los proveedores de tecnología establecidos, como Nuance, Microsoft y otros, luchaban por hacerse un hueco significativo.

Agentes de IA

Con la llegada de los agentes de IA, el ámbito de los proveedores de tecnología seguramente aumentará con empresas como ServiceNow y Salesforce que entrarán en el mercado de los agentes de IA. Forman parte de un grupo de empresas que antes no se consideraban en términos o como parte del mercado de chatbot o IA conversacional.

Junto con proveedores de nicho y centrados como LlamaIndex, LangChain.

También hay que tener en cuenta a los proveedores de modelos comerciales que buscan ampliar su alcance a las aplicaciones y acercarse al usuario final. Uno de los mejores ejemplos en este sentido es el proveedor de modelos Anthropic, que ha desarrollado un marco docker para una interfaz informática (como se ve a continuación).

La disrupción

La disrupción del ecosistema de los chatbots se desarrolló gradualmente al principio con mejoras incrementales, y luego, de repente, se aceleró rápidamente, remodelando el panorama casi de la noche a la mañana.

Comenzó con el desarrollo acelerado de NLU

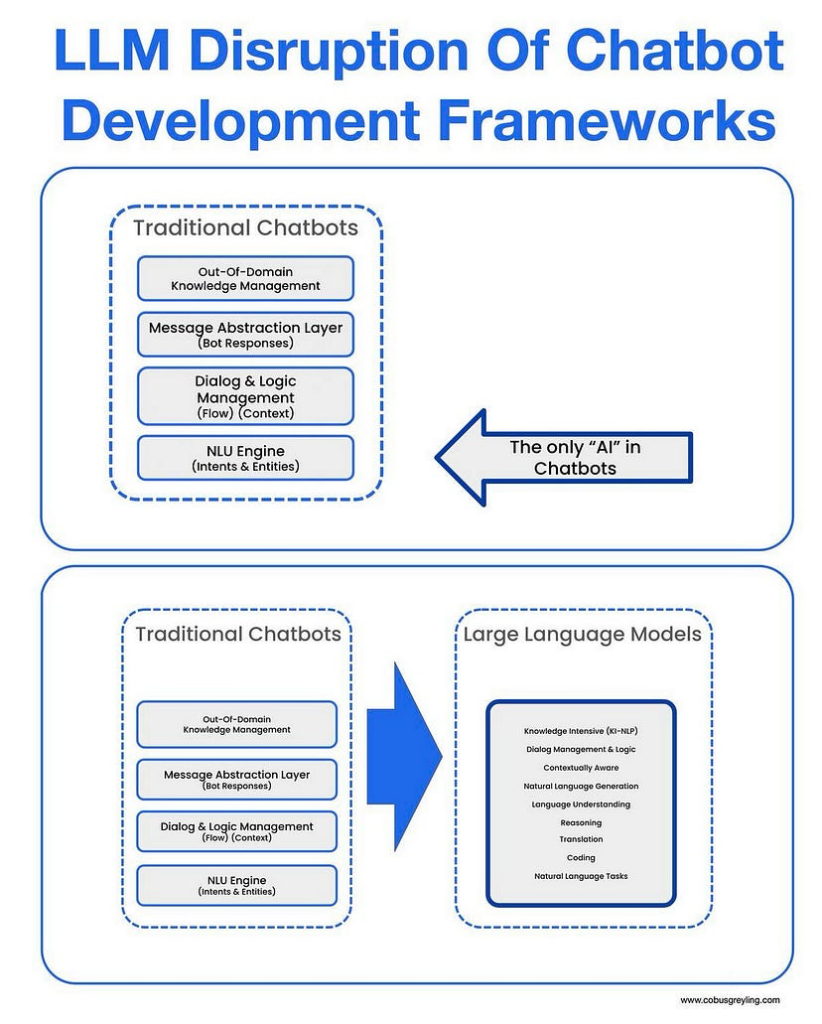

Los grandes modelos lingüísticos (LLM) revolucionaron inicialmente el ecosistema de los chatbots al acelerar el proceso de desarrollo de la comprensión del lenguaje natural (NLU).

A diferencia de los modelos tradicionales, los LLM se introdujeron en tiempo de diseño, no en tiempo de ejecución, mitigando riesgos como la latencia de inferencia y las respuestas aberrantes en producción.

Mejoraron el NLU agrupando expresiones de clientes semánticamente similares para la detección de intenciones, generando datos de entrenamiento y mejorando el reconocimiento de entidades con nombre. El resultado fue un desarrollo de NLU más rápido y preciso.

A continuación, se mejoraron la redacción y los personajes

La siguiente fase consistió en utilizar los LLM para la redacción de bots y el desarrollo de personajes, de nuevo aplicados en el momento del diseño.

Los LLM ayudaron a los desarrolladores a elaborar respuestas coherentes y adecuadas al contexto.

Los diseñadores pudieron definir el personaje, el tono y el estilo del bot, lo que dio lugar a interacciones más refinadas y coherentes.

Esta etapa también marcó la transición al uso en tiempo de ejecución, en el que los LLM empezaron a generar respuestas dinámicas del bot, gestionar consultas fuera del dominio y aumentar las búsquedas basadas en documentos.

Implementaciones avanzadas y RAG

En la tercera fase se introdujeron capacidades LLM más sofisticadas en tiempo de ejecución, como la Generación Aumentada de Recuperación (RAG), las preguntas y respuestas basadas en documentos y el encadenamiento de instrucciones.

Estas implementaciones permitieron un formato de datos más flexible, resúmenes y resultados estructurados.

El encadenamiento de avisos permitió flujos de diálogo más largos y complejos al pasar los resultados entre avisos secuenciales, lo que aumentó la flexibilidad y profundidad de la IA conversacional.

Superar los retos

Cuando se trata de modelos lingüísticos, las interfaces conversacionales se enfrentan a importantes retos, como la latencia, la desviación del modelo, los olvidos catastróficos y los elevados costes de inferencia.

Proveedores como Kore.ai abordan estos problemas permitiendo un despliegue sencillo y sin código de modelos de código abierto a nivel local o una instancia privada alojada.

Esto ayuda a reducir la latencia y a controlar los costes de inferencia. Este despliegue local también mitiga la deriva del modelo y el olvido catastrófico al mantener versiones del modelo coherentes y específicas para cada contexto.

Además, abordan el reto de crear una referencia contextual para los modelos, garantizando respuestas más precisas y pertinentes. Este enfoque holístico mejora el rendimiento y la fiabilidad de los sistemas de IA conversacional en aplicaciones del mundo real.

Introducción de los agentes de IA

La introducción de los agentes de inteligencia artificial ha traído consigo importantes trastornos y oportunidades…

Oportunidad

La irrupción de los Agentes de IA supuso un reto para los operadores tradicionales, pero también una gran oportunidad para los proveedores de tecnología que no estaban presentes en este mercado. Una vez más, consideremos aquí la gran cantidad de nuevas empresas fundadas con el entusiasmo de los Agentes de IA y también empresas como ServiceNow y Salesforce.

Muchas de las empresas tradicionales de chatbot surgieron desde la perspectiva de la atención al cliente y sirvieron como extensión o mejora de los marcos existentes de atención al cliente o experiencia del cliente.

En mi opinión, los nuevos participantes tienen la ventaja de considerar los casos de uso y los escenarios de implementación de una forma nueva e innovadora.

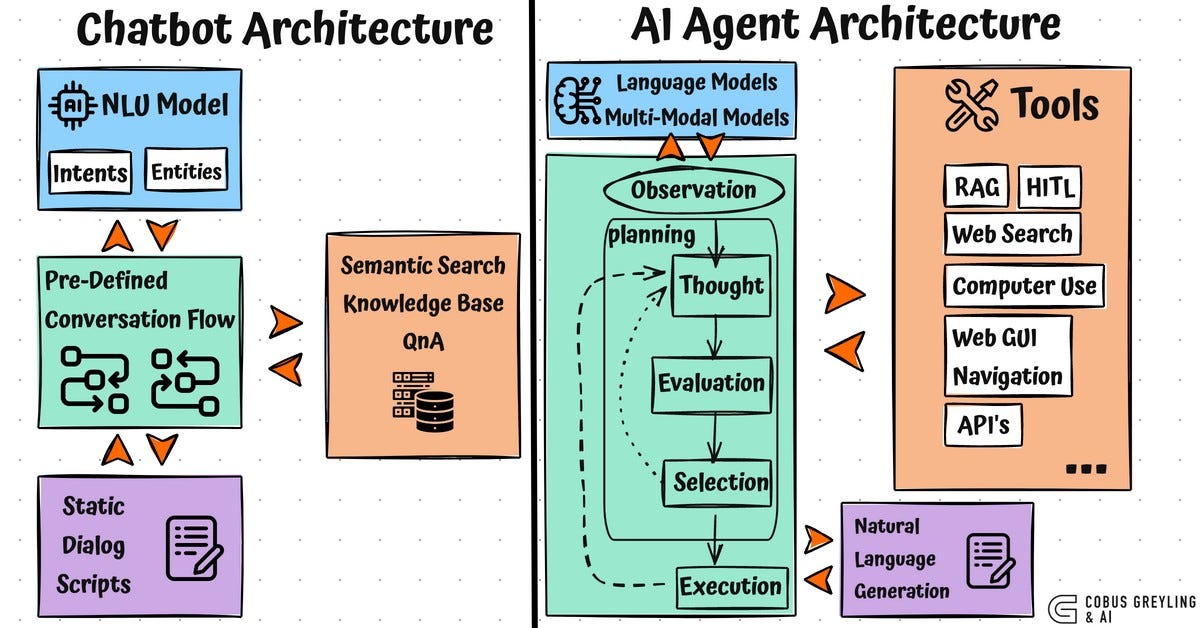

Los AI Agents han introducido una arquitectura completamente nueva, que supone un salto cualitativo con respecto a los marcos tradicionales de chatbot.

Disrupción

La arquitectura de agentes de IA ha alterado el panorama tan profundamente que los proveedores de plataformas de chatbot y de IA conversacional deben replantearse y rediseñar sus ofertas para ofrecer implementaciones auténticamente agénticas.

Muchos marcos de trabajo se están rebautizando como agentes de IA, aunque puede que carezcan de una verdadera funcionalidad de agente bajo la superficie.

El verdadero reto consiste en crear un marco que realmente apoye el desarrollo, la implantación, la gestión y la ampliación de los agentes de IA de una forma totalmente agencial.

Sígueme en LinkedIn

Chief Evangelist @ Kore.ai | Me apasiona explorar la intersección de la IA y el lenguaje. Desde modelos lingüísticos y agentes de IA hasta aplicaciones agenéticas, marcos de desarrollo y herramientas de productividad centradas en los datos, comparto ideas sobre cómo estas tecnologías están dando forma al futuro.