En los últimos años, he visto cómo el panorama de los datos ha evolucionado desde canales estáticos hasta plataformas dinámicas basadas en IA. Lo que antes consistía en mover datos del punto A al B ahora se trata de hacerlos accesibles, explicables y procesables, tanto para humanos como para sistemas inteligentes.

Este fin de semana, revisé los fundamentos del diseño de una plataforma de datos moderna, especialmente una diseñada para la era de la IA. Esto es lo que aprendí, implementé y visualicé.

Tabla de contenidos

Capítulo 1: ¿Por qué modernizarse?

“Los flujos de datos ya no son suficientes. Necesitamos inteligencia de datos.”

En una empresa impulsada por IA, tener datos no basta. Necesita:

- Datos actualizados y en tiempo real

- Unificados en todos los dominios (sin silos de datos)

- Descubribles para humanos y máquinas

- Gobernados y seguros desde el primer día

- Preparados para LLM, análisis y automatización

Los almacenes de datos tradicionales tienen dificultades con esto. Aquí es donde entra en juego la pila de datos moderna.

Capítulo 2: El plan de una plataforma de datos moderna

Esta es la arquitectura simplificada que utilicé en mi prototipo:

+------------------+ +------------------+ +------------------+

| Data Sources | ---> | Ingestion | ---> | Data Lake |

| (APIs, DBs, etc) | | (Kafka, Airbyte) | | (Delta, Iceberg) |

+------------------+ +------------------+ +------------------+

|

v

+------------------+ +------------------+ +------------------+

| Metadata + Tags |<---->| Catalog Layer |<---->| Enriched Data |

| (Alation, Atlan) | | (Unity, Datahub) | | (ELT/Quality) |

+------------------+ +------------------+ +------------------+

|

v

+------------------+ +------------------+

| Semantic Layer |----->| LLM/BI/Apps |

| (dbt, Cube.dev) | | (RAG, Dashboards)|

+------------------+ +------------------+

Capas clave:

- Ingesta: De procesamiento por lotes a tiempo real (Kafka, Airbyte)

- Almacenamiento: Data lakes con formatos de tabla abiertos como Delta Lake o Apache Iceberg

- Gobernanza: Metadatos, linaje y RBAC con Alation o Datahub

- Transformación: Modelado declarativo estilo DBT

- Preparación para IA: Integración con LLM y pipelines RAG

Capítulo 3: Haciéndolo compatible con IA

Una plataforma de datos moderna debe estar diseñada para el razonamiento automático.

Esto significa:

- Etiquetado de metadatos enriquecido (¿Qué es esta tabla? ¿Quién la posee?)

- Linaje claro y controles de calidad

- Datos semánticamente estructurados (términos de negocio > columnas sin procesar)

- Compatibilidad con el Protocolo de Contexto de Modelo (MCP) para que los agentes puedan razonar con las herramientas

Esto es lo que ve la IA:

"task": "Find top customers by revenue in Q1",

"metadata": {

"data_source": "gold.sales_customers",

"business_term": "revenue",

"time_filter": "Q1"

}

Ahora, un LLM puede generar:

- Consultas SQL

- Paneles visuales

- Alertas

- Flujos de trabajo de Agentic

Capítulo 4: Herramientas que utilicé

+---------------------+-----------------------------+

| Tool | Role |

+---------------------+-----------------------------+

| Apache Kafka | Stream ingestion |

| dbt | Transformations |

| Delta Lake | Storage format |

| LangChain + MCP | LLM integration layer |

| Alation | Metadata and governance |

| Streamlit | UI for interaction |

+---------------------+-----------------------------+

Bono: si trabajas con código abierto, herramientas como OpenMetadata, DataHub y Prefect son excelentes alternativas.

Capítulo 5: Por qué es importante

Esto no es solo un ejercicio de ingeniería.

Se trata de:

- Desbloquear las capacidades de IA para cada equipo

- Permitir el acceso a los datos mediante lenguaje natural

- Capacitar a los agentes para crear pipelines, generar SQL y responder preguntas

- Crear un sistema auditable, explicable y reutilizable

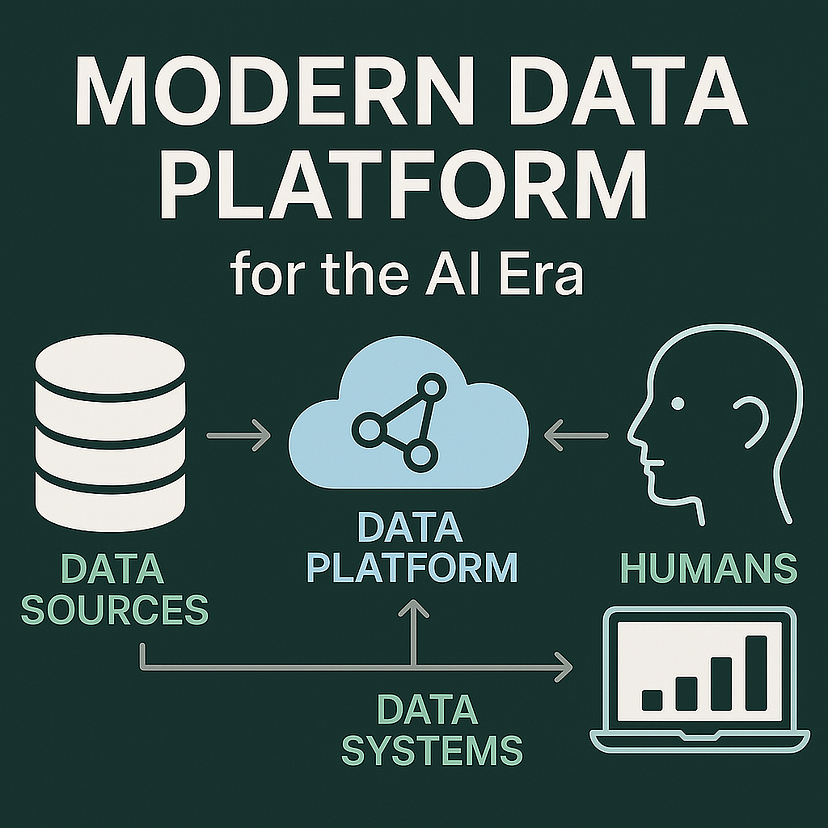

Elementos visuales de apoyo

También he creado algunas ilustraciones para simplificar estos conceptos:

- Flujo de datos preparado para IA

- Acceso humano y automático a los metadatos

- LangChain + MCP + Capa RAG

(¡Avísame si quieres versiones en alta resolución!)

Reflexiones finales

Este viaje reafirmó una convicción que tenía desde hacía tiempo: las plataformas de datos deben servir tanto a humanos como a máquinas.

Al combinar el diseño centrado en metadatos, formatos abiertos e integración LLM, finalmente podemos construir sistemas que no solo se basan en datos, sino también en inteligencia.

Reimaginemos lo que es posible.

¿Te gustaría una plantilla descargable, diagramas o un repositorio para probarlo tú mismo? Deja un comentario. ¡Me encantaría compartirlo!