¿Y si te dijera que una neurona biológica está mejor representada por una red neuronal artificial completa que por una sola neurona artificial?

El Deep Learning, con la ayuda de grandes conjuntos de datos de entrenamiento y enormes recursos informáticos, experimentó una ola de éxito como ninguna otra a principios de la década de 2010. Pronto, la Inteligencia Artificial, el Machine Learning y el Deep Learning fueron el centro de una revolución tecnológica. Y junto a ellos estaba otro concepto: redes neuronales artificiales (ANNs).

Lo que la mayoría de la gente no sabe es que ninguno de esos conceptos es ni remotamente nuevo. La IA nació como campo de investigación en 1956. ML y DL se introdujeron en 1959 y 1986, respectivamente. Y las redes neuronales artificiales, un término tomado del inmaduro campo de la neurociencia en ese momento, aparecieron en 1943, con el trabajo pionero de Warren S. McCulloch y Walter Pitts.

Su trabajo ahora se considera el primero en inteligencia artificial. Como subcampo de la IA, las ANN pasaron por tiempos de desinterés y oscuridad hasta que la revolución del aprendizaje profundo las elevó al pico más alto en la historia de la IA.

Tabla de contenidos

La primera red neuronal artificial

Fue en los primeros días de la informática (la IA ni siquiera tenía un nombre) cuando se creó la primera ANN. Los neurocientíficos habían estado modelando neuronas biológicas durante décadas, pero el trabajo de McCulloch y Pitts fue el primero en describir una neurona biológica en términos de lógica proposicional.

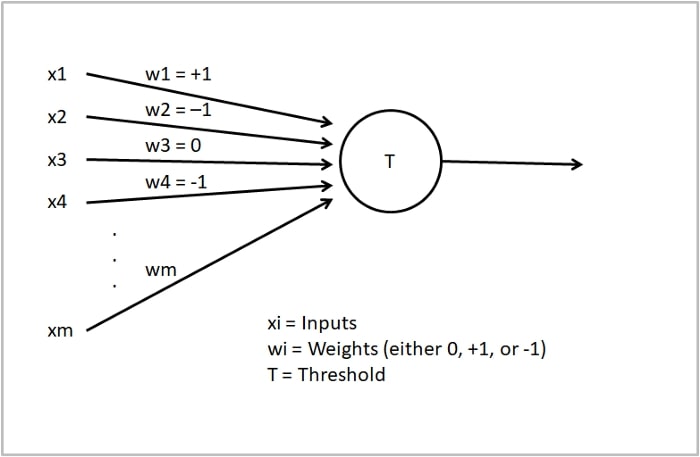

Los que estéis familiarizados con las ANN reconoceréis esta imagen:

Este es el modelo de neuronas de McCulloch y Pitts (MCP), concebido hace casi 80 años. Es, en su mayor parte, el mismo modelo que se enseña en todos los cursos de introducción o libros modernos sobre Deep Learning. No se debe a que MCP sea un modelo preciso que no necesita refinamiento, sino a que el aprendizaje profundo no ha cambiado nada en este nivel elemental desde 1943.

La neurona MCP estaba destinada a representar solo una versión neurofisiológica simplificada de las neuronas biológicas: una serie de entradas entran en la neurona que las procesa y luego genera una salida o no. Tenía una función de activación de umbral: si la suma de las entradas es negativa, la salida es 0. De lo contrario, es 1.

Las ANN actuales tienen entradas ponderadas y funciones de activación no lineales más complejas para permitir un aprendizaje significativo y un mapeo de E / S más preciso. Pero son solo una versión ligeramente mejorada del modelo MCP. La base es la misma; algunos insumos ponderados se transforman en un producto. Si la neurona aprende bien o no, es irrelevante para el hecho de que estos modelos no se asemejan, ni siquiera vagamente, a una neurona biológica real.

La principal simplificación y la que más perjudica al modelo MCP es que cada neurona de la RNA se colapsa en un solo punto en el espacio. Esto es suficiente para simular el comportamiento de algunas neuronas, pero la naturaleza biofísica de otras neuronas más complejas es demasiado matizada e intrincada.

La electricidad fluye a través de las dendritas, el soma y los axones a través del espacio y el tiempo. No todas las dendritas funcionan de la misma manera. No todas las entradas participan en la generación de las salidas: el voltaje disminuye a lo largo de las dendritas. La morfología del árbol dendrítico, los patrones sinápticos y los diferentes tipos de receptores influyen en el comportamiento neuronal. Y hay muchos más mecanismos y procesos elementales que forman las bases que eventualmente dan lugar a nuestra inteligencia.

Ninguna de esas características se describe en los modelos MCP o ANN actuales.

Cuando se ideó la neurona MCP, la neurociencia ya sabía que las neuronas tenían características que las hacían no reducibles a una neurona de punto espacial. McCulloch y Pitts simplificaron las complejidades para hacer un modelo basado en la lógica.

En el proceso, sentaron las bases de todo un campo que nunca se dignó volver a mirar sus propias premisas y contrastarlas con descubrimientos relevantes en neurociencia.

La complejidad de las neuronas biológicas

El modelo MCP se creó hace casi 80 años. Desde entonces, la neurociencia se ha desarrollado drásticamente y nuestra comprensión de las neuronas ha llegado a un punto en el que ya no podemos seguir llamando a las neuronas artificiales «neuronas». Recordemos algunas de las investigaciones más relevantes sobre el tema para ilustrar hasta qué punto la IA se ha alejado de las ciencias cognitivas.

Neuronas y dendritas: procesadores dentro de procesadores

En los años 80, Christof Koch y otros descubrieron que la morfología dendrítica y los patrones sinápticos podían influir en cómo las neuronas procesaban internamente las entradas. Durante mucho tiempo, los científicos pensaron que las dendritas se comportaban de manera uniforme y sumaban pasivamente las entradas. Los experimentos de Koch llevaron a la conclusión de que las neuronas son mucho más complejas que eso.

Más recientemente, los neurocientíficos investigaron el papel de las dendritas individuales y descubrieron que ellas mismas actúan como unidades de procesamiento: las dendritas tienen su propio umbral para generar picos (llamados picos dendríticos), que es diferente al umbral de toda la neurona.

Es decir, las neuronas no son simples «puertas lógicas», como sugiere el modelo MCP. Las dendritas parecen ser capaces de actuar ellas mismas como puertas lógicas. Por tanto, una neurona biológica es un sistema de procesamiento que, a su vez, está compuesto por sistemas de procesamiento independientes.

Para representar esto en las RNA, las conexiones entre neuronas necesitarían tener morfologías distintas que afectarían su función cada vez que la neurona genera una salida. Y esas conexiones actuarían internamente como sistemas de procesamiento: cada conexión de entrada que llega a la neurona generaría, internamente, o no un pico que cambiaría radicalmente la salida general de la neurona.

Esto significa que una neurona artificial se entiende mejor como una red en capas, en la que las capas (dendritas) funcionan como asignaciones de E / S intermedias no lineales. Las salidas intermedias resultantes se suman luego de acuerdo con la morfología del «árbol de conexión» para producir la salida final.

Sobre la base de estos sorprendentes descubrimientos, Albert Gidon y sus colegas publicaron un artículo pionero en Science el año pasado. Encontraron una nueva característica de E / S en neuronas humanas piramidales que no fue descrita por los modelos actuales. Las dendritas de estas neuronas produjeron un tipo de pico en el que la intensidad era más alta para los estímulos en el nivel de umbral y más baja cuando aumentaba la corriente eléctrica entrante.

Su descubrimiento demostró que algunas dendritas pueden actuar como puertas lógicas XOR: la salida es verdadera si y solo si una de las entradas es verdadera. En 1969, Minsky y Papert demostraron que un perceptrón de una sola capa, un tipo inicial básico de ANN, no podía realizar este tipo de cálculo. Ahora, está claro que una sola dendrita biológica puede hacerlo. Eso es dos grados de complejidad más alto; de una sola dendrita a una sola neurona, a una simple RNA.

Si una dendrita puede funcionar al nivel de las ANN, entonces, ¿cuánto más complejas son las neuronas biológicas en comparación con las neuronas artificiales?

Se necesitan 1000 neuronas artificiales para simular 1 neurona biológica

Hace unos días, David Beniaguev y sus colegas publicaron un artículo en Neuron que prueba lo que se ha sugerido todos estos años: una neurona artificial no puede representar con precisión una neurona biológica en absoluto.

Para probar esto, decidieron utilizar técnicas modernas de aprendizaje automático para simular el comportamiento de E / S de una neurona humana piramidal. Querían probar dos cosas: si una ANN puede predecir con precisión las salidas neuronales cuando se entrena en pares de E / S reales, y qué tan grande debe ser la ANN para capturar toda la complejidad de una neurona biológica con precisión.

Descubrieron que, como mínimo, se necesita un TCN de 5 capas y 128 unidades (red convolucional temporal) para simular los patrones de E / S de una neurona piramidal con una resolución de milisegundos (precisión de un solo pico). Modificaron la profundidad y el ancho y descubrieron que el mejor rendimiento se lograba con un TCN de 256 unidades y 8 capas.

Para hacer una comparación burda: esto significa que una sola neurona biológica necesita entre 640 y 2048 neuronas artificiales para ser simulada adecuadamente. No implica que una neurona biológica tenga mucho más poder o complejidad computacional. Sin embargo, es una clara señal de que ambos tipos de neuronas están más separados en forma y sustancia de lo que se pensaba anteriormente.

Los investigadores pudieron precisar los mecanismos exactos por los que la neurona biológica era tan difícil de simular: la morfología dendrítica y la presencia de un tipo específico de receptor de sinapsis llamado NMDA. Ambos son aspectos estructurales y funcionales de las neuronas bien conocidos en neurociencia durante mucho tiempo, pero completamente ignorados en la IA y las RNA modernas.

Algunas preguntas surgen de estos resultados: ¿Por qué la comunidad de IA no ha intentado remodelar sus cimientos para adaptarse mejor a la realidad que están tratando de simular? ¿La IA está destinada a fracasar en su búsqueda por lograr AGI hasta que esos cimientos sean derrocados y reconstruidos desde cero? ¿Cuáles serían las consecuencias de cambiar la IA a un nivel tan elemental?

Veamos cómo se desarrolla todo esto.

Inteligencia artificial y neurociencia: caminos divergentes

Las neuronas de nuestro cerebro, aunque no todas, son mucho más complejas que sus contrapartes artificiales. Sería razonable abordar este problema comprobando si las suposiciones establecidas por la inteligencia artificial y el aprendizaje profundo aún se mantienen a pesar de los recientes, y no tan recientes, descubrimientos en neurociencia.

Puede darse el caso de que la IA siga funcionando perfectamente sin cambiar nada. Continuaría su camino hacia AGI a pesar de las aparentes diferencias entre las estructuras neuronales digitales y biológicas. Sin embargo, parece que casi nadie en la IA se preocupa lo suficiente como para comprobarlo.

La razón es que, desde los primeros días, la neurociencia y la inteligencia artificial se separaron, aunque ambos campos están tratando de responder preguntas estrechamente relacionadas. La neurociencia se ocupa de la inteligencia, el cerebro y la mente. Los neurocientíficos decidieron mirar hacia adentro, a la única instancia de inteligencia que conocemos; nosotros. Por el contrario, la IA se preocupa por replicar la inteligencia utilizando medios artificiales. Se preocupan por diseñar y construir agentes inteligentes que puedan percibir el mundo y actuar en consecuencia.

La neurociencia es una ciencia pura cuyo propósito es encontrar la verdad. Lo impulsa la curiosidad y el hambre de conocimiento. La IA, al menos la IA a corto plazo, está impulsada en gran medida por el dinero y la utilidad. A la gente de la industria no le preocupa que la base misma de todo el aprendizaje profundo pueda desmoronarse en pedazos si lo analizamos cuidadosamente. Les importa que la IA siga atrayendo fondos y que sus modelos parezcan funcionar de alguna manera, aunque sea irrazonable.

La neurociencia sigue revisando una y otra vez sus fundamentos, pero la inteligencia artificial ha optado por otro camino: hicieron las suposiciones y siguieron adelante sin mirar atrás ni una sola vez.

Los niveles en los que ambos campos están trabajando y desarrollándose no son los mismos, pero no es justo decir que todos en la IA lo ven desde una perspectiva tecnológica impulsada por el dinero. Hay gente que trabaja muy duro para hacer avanzar el campo como ciencia. Aquellos que todavía ven el campo como un medio para resolver la inteligencia y cumplir con la misión original de los padres fundadores de la IA: la inteligencia artificial general.

Reconocen la distinción entre la IA útil que funciona bien para tareas simples y limitadas y se está implementando en todas partes, y la IA desafiante que necesita avances importantes para pasar al siguiente nivel. En el último caso, hay un debate en curso sobre cuál es el mejor camino a seguir. Mientras que algunos argumentan que el aprendizaje profundo es el camino (puede que necesite algunos ajustes, pero eventualmente funcionará), otros piensan que nunca será suficiente por sí solo.

Pero, ¿es eso sobre lo que deberían estar debatiendo?

¿Está la comunidad de IA enfocada en los problemas equivocados?

Este debate debería estar sucediendo si y solo si todos los debates de nivel inferior se cierran y se acuerdan. Sin embargo, nada más lejos de la verdad. La piedra angular más baja posible bajo la cual se cree que el aprendizaje profundo es el camino hacia el futuro de la IA permanece en duda: las neuronas artificiales pueden ser demasiado diferentes de las neuronas biológicas como para dar lugar a procesos cognitivos complejos e inteligencia similar a la humana.

Podríamos compensar la falta de complejidad en las neuronas artificiales con modelos más grandes, toneladas de potencia informática y conjuntos de datos gigantes, pero eso es demasiado ineficiente para ser el último paso de esta búsqueda.

Sin embargo, esas son las prioridades de la industria de la inteligencia artificial. ¿Cómo pueden fabricar chips que no pierdan ancho de banda mientras mantienen la eficiencia? O apilan GPU o fabrican / compran chips especializados (solo al alcance de los más ricos). ¿Cómo pueden extraer y seleccionar conjuntos de datos cada vez más grandes? Aprendizaje no supervisado y etiquetado automático. ¿Cómo pueden crear y entrenar modelos más grandes? O son una gran empresa de tecnología o necesitarán solicitar financiación a una.

Siguen encontrando soluciones, pero ¿esta tendencia es sostenible? No lo parece. Es posible que tengamos que volver a lo básico. No solo porque no podremos construir AGI de esta manera, sino porque estamos empezando a sentir la carga colateral de negar la ineficiencia de la IA actual.

Pero aquí está el truco; Si descubren que realmente necesitan hacer un cambio, todo el campo de la IA tal como lo conocemos necesitaría una restauración completa. Y simplemente no están dispuestos a aceptar eso. Los líderes de la industria de la IA pueden incluso saber que los cuellos de botella de la IA son intransitables. Pero es posible que simplemente prefieran actuar como si no importara para no tener que afrontar el coste de haber construido todo esto sobre supuestos erróneos.

Sin embargo, hay una aclaración importante que hacer aquí. Algunos sistemas de IA funcionan bien y no contaminan tanto. La IA sigue siendo una disciplina tecnológica increíblemente útil que está aportando mucha innovación en muchas industrias. No lo niego. Pero esa es la excepción a la regla. Hay una carrera en curso para crear IA más poderosas y todos los jugadores importantes están allí, luchando por obtener una parte del pastel.

Como he dicho antes, el progreso no debería tener ningún costo.

Las RNA deberían estar más basadas en la neurociencia por dos razones, una que mira al futuro y otra que mira al presente: primero, la diferencia de complejidad entre las neuronas biológicas y artificiales dará como resultado diferencias en el resultado: la AGI no vendrá sin un reforma -, y segundo, la ineficiencia con la que perseguimos este objetivo está dañando nuestra sociedad y el planeta.

¿Vale la pena?

Las consecuencias: para la IA y el mundo

Incluso si la comunidad de IA no actúa con respecto a los hechos que he descrito aquí, la IA, como la industria fértil que es, seguirá trayendo una gran cantidad de nuevos proyectos de investigación y aplicaciones útiles cada año.

Los sistemas de IA estrechos seguirán teniendo éxito en las tareas simples para las que están hechos a pesar de que la IA no se acerque a la neurociencia. Las redes neuronales artificiales seguirán siendo populares ya sea que la comunidad de IA acepte o no que las neuronas biológicas son mucho más complejas que las artificiales. La industria de la IA aún se beneficiará enormemente de perseguir la búsqueda de AGI, ya sea que se logre o no eventualmente; la IA cercana a AGI también puede cambiar el mundo, para bien o para mal. Y también se mantendrá el deseo de seguir elevando el nivel de vida de las personas privilegiadas del mundo desarrollado.

¿Pero a qué costo?

Las preocupaciones éticas en la IA están en su apogeo y los modelos no parecen mejorar. Hace solo unos días, el New York Times informó que un sistema de inteligencia artificial de Facebook había etiquetado a un grupo de hombres negros como primates. Otra IA creada por Google mostró el mismo sesgo dañino en 2015. ¿Vamos a ignorar todo esto y poner una curita al problema, como lo hizo Google al eliminar a los gorilas del conjunto de datos de entrenamiento?

Hacer que la IA sea explicable, interpretable y responsable es la clave para resolver estos problemas. Esas son áreas calientes dentro de la IA, pero su objetivo es resolver el problema a posteriori. En lugar de Pero, ¿cómo podríamos hacerlo si no hay bases teóricas sólidas detrás de las ANN? No hay ningún modelo neuronal que pueda explicar el comportamiento de las redes neuronales. Los usamos para predecir y pronosticar porque funcionan, pero no sabemos por qué.

Con la mitad del planeta en llamas y la otra mitad ahogándose en inundaciones inesperadas, la catástrofe climática está a la vuelta de la esquina. Y la IA no está ayudando. Su huella de carbono general es insostenible.

En 2019, investigadores de la Universidad de Massachusetts Amherst estudiaron el impacto ambiental de los grandes modelos de lenguaje (LLM), cada vez más populares hoy en día con GPT-3 como punta de lanza, y encontraron que entrenar uno de estos grandes modelos genera alrededor de 300.000 kg de emisiones de CO2; lo mismo que 125 vuelos de ida y vuelta Nueva York-Beijing, dice Payal Dhar for Nature. Algunas grandes empresas de tecnología (Google, Facebook) están trabajando ahora para reducir este problema y cambiar gradualmente a las energías renovables.

Relacionado con este problema es que las ANN son extremadamente ineficientes. Para aprender las tareas más simples, necesitan inmensas cantidades de potencia informática. Esa es la razón por la que estos sistemas generan una huella de carbono tan grande. La ineficiencia conduce a una mayor explotación de los recursos, lo que genera más contaminación.

Los cerebros humanos contaminan solo una fracción de eso y no consumen casi la misma cantidad de energía para aprender o hacer las mismas cosas. El cerebro es un órgano extremadamente eficiente. ¿Cómo podemos hacer cosas tan complejas cuando el cerebro usa tan poca energía, sin mencionar que es mucho más lento que las computadoras? ¿Podría la razón de esta diferencia extrema ser que la complejidad de las estructuras subneuronales es mucho mayor que la de las ANN? Sí, podría ser.

Los LLM, reservados para los grandes actores, son los que atraen la atención de los inversores y los medios de comunicación. La razón es que estos modelos siempre vienen rodeados de una exageración que se transmite al público: «Los robots ahora pueden leer mejor que los humanos«, «GPT-3 […] es increíblemente bueno para sonar humano«, «un robot escribió todo este artículo. ¿Estás asustado todavía, humano?»

Las promesas excesivas y las entregas deficientes son la marca comercial de la industria de la inteligencia artificial. Pero no toda la comunidad de IA participa en la venta de algo que no tiene con el único propósito de generar publicidad y atraer dinero.

En palabras de Emily M. Bender, profesora de lingüística computacional en la Universidad de Washington: «Los LLM y las promesas excesivas asociadas absorben el oxígeno de la sala para todos los demás tipos de investigación». Además de los LLM, se están realizando investigaciones cruciales que las instituciones de financiación y los medios de comunicación están descuidando.

“[B] eado que estos grandes reclamos están ahí, y debido a que los LLM logran arrasar los puntos de referencia al manipular la forma, otro trabajo con un alcance más cuidadoso, probablemente basado en contextos de aplicación muy específicos que no hacen que los reclamos excesivos sean mucho más difíciles de publicar . »

– Emily M. Bender

Tal vez parte de esa investigación que se está perdiendo en el olvido está tratando de alertar a aquellos con ojos solo para los LLM brillantes de que estamos haciendo IA mal. Quizás algunas personas están trabajando en vano en estos problemas exactos que estoy describiendo.

Si las ANN tienen una base errónea, solo los LLM parecen importar, y solo las grandes empresas de tecnología pueden construirlos e implementarlos, entonces existe un riesgo muy real de que la industria de la IA sea efectivamente un oligopolio centrado en los objetivos equivocados. Y no habría nadie capaz de alzar la voz lo suficiente para que los responsables sepan lo equivocados que están.

Parece, como se mire, que la IA y, en particular, las ANN tienen problemas de suma importancia que resolver. Incluso si los repensamos desde sus mismos cimientos, es improbable que los problemas se resuelvan de inmediato.

Si queremos comprender el panorama general y descubrir nuevos caminos que pueden sugerir que nos hemos estado dirigiendo hacia un máximo local todo este tiempo, mirar la neurociencia y reconocer sus descubrimientos es el primer paso.

Tal vez la solución sea no intentar imbuir de inteligencia a las computadoras. La evolución encontró una forma mejor. Estamos tratando de replicar digitalmente lo que se puede hacer en el ámbito físico. ¿Por qué no intentar crear redes neuronales artificiales físicas basadas en silicio? Usar una computadora fue la propuesta de Turing, pero hemos recorrido un largo camino desde la década de 1950. Quizás la computación neuromórfica tenga la respuesta que deberíamos estar buscando.

Es posible que la comunidad de IA no reconstruya todo desde cero, pero al menos deberían tomar estas dos acciones: Primero, reconocer las limitaciones y deficiencias de los paradigmas de IA actuales, principalmente las RNA, y tenerlas en cuenta tanto para la investigación futura como para las promesas. ellos hacen. En segundo lugar, trabaje para realizar los ajustes pertinentes en la teoría y la práctica.

Pueden decidir continuar con la IA y las ANN exactamente como son hoy, pero al menos no será por ignorancia calculada, sino por una sincera falta de voluntad.

Si te gustó este artículo, ¡considera suscribirte a mi boletín semanal gratuito Minds of Tomorrow! ¡Noticias, investigaciones y conocimientos sobre inteligencia artificial cada semana!

¡También puedes apoyar mi trabajo directamente y obtener acceso ilimitado al convertirse en miembro de Medium usando mi enlace de referencia aquí! 🙂