Estas arquitecturas son mucho más que simples modelos avanzados: están surgiendo bloques de construcción definitivos que permitirán a los Agentes de IA y a las aplicaciones actuar de forma autónoma, adaptarse dinámicamente e interactuar y explorar sin problemas dentro de los entornos digitales.

Y a medida que los Agentes de IA se vuelven más capaces, los constructores convergen en los principios y enfoques comunes de los componentes básicos.

Quiero hacer una advertencia: aunque hay muchas especulaciones futuristas sobre los agentes de IA, el descubrimiento de agentes y las aplicaciones de agentes, las ideas y comentarios que comparto aquí se basan en trabajos de investigación concretos y en la experiencia práctica con prototipos que he construido o bifurcado y probado en mi propio entorno.

Pero antes, preparemos el terreno con algunos conceptos clave…

Tabla de contenidos

¿Qué son los agentes de IA?

A alto nivel, un agente de IA es un sistema diseñado para realizar tareas de forma autónoma o semiautónoma. Considerando la semiautonomía por un momento, los agentes hacen uso de herramientas para lograr su objetivo, y un humano en el bucle puede ser una herramienta.

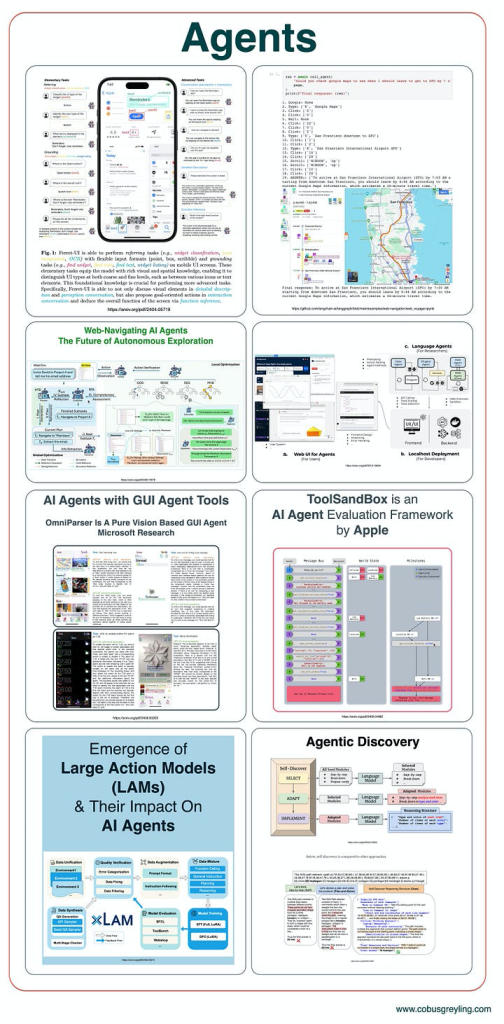

Las tareas de los agentes de IA pueden ir desde un asistente virtual que programe tus citas, hasta agentes más complejos implicados en la exploración e interacción con entornos digitales. En lo que respecta a los entornos digitales, las investigaciones más destacadas son las de Apple con Ferret-UI, WebVoyager, y las de Microsoft y otros…

Un Agente de IA es un programa que utiliza uno o varios Modelos de Lenguaje Extensos (LLM) o Modelos Fundamentales (FM) como columna vertebral, lo que le permite operar de forma autónoma.

Al descomponer las consultas, planificar y crear una secuencia de eventos, el Agente de IA aborda y resuelve eficazmente problemas complejos.

Los Agentes de IA pueden manejar preguntas muy ambiguas descomponiéndolas a través de una cadena de procesos de pensamiento, similar al razonamiento humano.

Estos agentes tienen acceso a diversas herramientas, como programas, API, búsquedas en Internet, etc., para realizar tareas y encontrar soluciones.

Grandes modelos de acción (LAM)

Al igual que los grandes modelos lingüísticos (LLM) transformaron el procesamiento del lenguaje natural, los grandes modelos de acción (LAM) están a punto de revolucionar la forma en que los agentes de IA interactúan con su entorno.

En un artículo reciente, exploré la aparición de los modelos de acción de gran tamaño (LAM) y su futuro impacto en los agentes de IA.

Salesforce AI Research ha puesto a disposición pública una serie de LAM, incluido un Small Action Model.

Los LAM están diseñados para ir más allá de la simple generación de lenguaje, ya que permiten a la IA realizar acciones significativas en escenarios del mundo real.

La llamada a funciones se ha convertido en un elemento crucial en el contexto de los agentes de IA, sobre todo desde el punto de vista de la capacidad de los modelos, porque amplía significativamente la funcionalidad de los grandes modelos de lenguaje (LLM) más allá de la generación de texto.

Y de ahí una de las razones de la aparición de los modelos de acción de gran tamaño, que tienen como uno de sus rasgos principales la capacidad de sobresalir en la llamada a funciones.

Los agentes de IA a menudo necesitan realizar acciones basadas en la entrada del usuario, como recuperar información, programar tareas o realizar cálculos.

La llamada a funciones permite al modelo generar parámetros para estas tareas, permitiendo al agente desencadenar procesos externos como consultas a bases de datos o llamadas a API.

Orquestación de modelos y aprovechamiento de pequeños modelos lingüísticos

Mientras que los LAM forman la columna vertebral de la acción, la orquestación de modelos reúne modelos lingüísticos más pequeños y especializados (SLM) para ayudar en tareas específicas.

En lugar de depender únicamente de modelos masivos que consumen muchos recursos, los agentes pueden utilizar estos modelos más pequeños en tándem, orquestándolos para funciones específicas, ya sea resumir datos, analizar comandos de usuario o proporcionar información basada en el contexto histórico.

Los modelos lingüísticos pequeños son ideales para el desarrollo y las pruebas, ya que se ejecutan localmente sin conexión.

Los grandes modelos lingüísticos (LLM) han ganado adeptos rápidamente debido a varias características clave que se ajustan bien a las exigencias del procesamiento del lenguaje natural. Estas características incluyen la generación de lenguaje natural, el razonamiento de sentido común, la gestión del contexto de diálogos y conversaciones, la comprensión del lenguaje natural y la capacidad de manejar datos de entrada no estructurados. Aunque los LLM requieren muchos conocimientos y han demostrado ser herramientas potentes, no están exentos de limitaciones.

Un inconveniente importante de los LLM es su tendencia a alucinar, lo que significa que pueden generar respuestas coherentes, contextualmente precisas y plausibles, pero objetivamente incorrectas.

Además, los LLM están limitados por el alcance de sus datos de entrenamiento, que tienen una fecha de corte fija. Esto significa que no poseen conocimientos continuos y actualizados ni perspectivas específicas adaptadas a sectores, organizaciones o empresas concretas.

Actualizar un LLM para subsanar estas carencias no es sencillo; requiere ajustar el modelo base, lo que implica un esfuerzo considerable en preparación de datos, costes y pruebas. Este proceso introduce un enfoque complejo y poco transparente de la integración de datos en los LLM.

Para subsanar estas deficiencias, se ha introducido el concepto de Generación Mejorada por Recuperación (RAG).

La RAG ayuda a salvar las distancias que separan a los pequeños modelos lingüísticos (SLM), complementándolos con las capacidades de conocimiento profundo e intensivo de las que suelen carecer.

Mientras que los SLM gestionan de forma inherente otros aspectos clave, como la generación y comprensión del lenguaje, la RAG los equipa para rendir de forma comparable a sus homólogos de mayor tamaño mediante la mejora de su base de conocimientos.

Esto convierte a la RAG en un ecualizador crítico en el ámbito de los modelos lingüísticos de IA, ya que permite que modelos más pequeños funcionen con la solidez de un LLM a gran escala.

Modelos lingüísticos con visión para la exploración digital

A medida que los agentes de IA adquieren capacidades para explorar entornos digitales e interactuar con ellos, la integración de las capacidades de visión con los modelos de lenguaje se vuelve crucial.

Proyectos como Ferret-UI de Apple y WebVoyager son excelentes ejemplos de ello.

Estos agentes pueden navegar en su entorno digital, ya sea identificando elementos en una interfaz de usuario o explorando sitios web de forma autónoma.

Imaginemos un agente de IA al que se le encargara configurar una aplicación en un entorno nuevo: no solo leería instrucciones basadas en texto, sino que también reconocería elementos de la interfaz de usuario mediante OCR, mapeando cuadros delimitadores e interpretando texto para interactuar con ellos, y proporcionaría información visual.

Llamadas a funciones y resultados estructurados

Se está produciendo un cambio fundamental en la forma en que los agentes de IA gestionan las entradas y salidas.

Tradicionalmente, los LLM han operado con entradas no estructuradas y han generado salidas no estructuradas: breves párrafos de texto o respuestas. Pero ahora, con la llamada a funciones, estamos avanzando hacia resultados estructurados y procesables.

Mientras que los LLM son excelentes para comprender y producir contenidos no estructurados, los LAM están diseñados para salvar las distancias convirtiendo el lenguaje en acciones estructuradas y ejecutables.

Cuando un agente de IA puede estructurar su salida para alinearla con funciones específicas, puede interactuar con otros sistemas de forma mucho más eficaz.

Por ejemplo, en lugar de generar una respuesta de texto meramente no estructurada/conversacional, la IA podría llamar a una función específica para reservar una reunión, enviar una solicitud o activar una llamada API, todo ello dentro de un uso de tokens más eficiente.

Esto no sólo reduce la sobrecarga de procesar respuestas no estructuradas, sino que también hace que las interacciones entre sistemas sean más fluidas.

Algo a tener en cuenta en términos de llamadas a funciones, es que cuando se utiliza la API de OpenAI con llamadas a funciones, el modelo no ejecuta funciones directamente.

Los agentes de IA ya pueden formar parte del ecosistema digital más amplio.

El papel de las herramientas: canales y participación humana en el proceso

Por último, hablemos de la importancia de las herramientas en la arquitectura de los agentes de IA.

Las herramientas pueden considerarse como los mecanismos a través de los cuales los agentes de IA interactúan con el mundo, ya sea para obtener datos, realizar cálculos o ejecutar tareas. En muchos sentidos, estas herramientas son como canales que llevan información de una etapa a otra y la transforman en el proceso.

Lo que es aún más fascinante es que una herramienta no necesariamente tiene que ser un algoritmo o un script. En algunos casos, la herramienta puede ser una participación humana en el proceso, donde los humanos intervienen en momentos clave para guiar o validar las acciones del agente.

Esto es particularmente valioso en entornos de alto riesgo, como la atención médica o las finanzas, donde la precisión absoluta es fundamental.

Las herramientas no solo amplían las capacidades de los agentes de IA, sino que también sirven como el pegamento que mantiene unidos a los distintos sistemas. Ya sea una función humana o digital, estas herramientas permiten que los agentes de IA se vuelvan más potentes, modulares y sensibles al contexto.

El futuro de los agentes de IA

En este momento en que nos encontramos en la cúspide de esta nueva era, resulta evidente que los agentes de IA se están volviendo mucho más sofisticados de lo que jamás habíamos previsto.

Con modelos de acción de gran tamaño, orquestación de modelos, modelos de lenguaje basados en visión, llamadas de funciones y el papel fundamental de las herramientas, estos agentes son participantes activos en la resolución de problemas, la exploración de paisajes digitales y el aprendizaje autónomo.

Al centrarnos en estos componentes básicos, estamos sentando las bases para que los agentes de IA no solo sean más inteligentes, sino también más adaptables, eficientes y capaces de actuar de maneras que comienzan a parecerse a la resolución de problemas y los procesos de pensamiento humanos.

Sígueme en LinkedIn para estar al día sobre la IA conversacional

Actualmente soy el Evangelista Jefe @ HumanFirst. Exploro y escribo sobre todas las cosas en la intersección de la IA y el lenguaje; que van desde LLMs, Chatbots, Voicebots, marcos de desarrollo, espacios latentes centrados en datos y más.